¿Harto de los Errores de ‘Memoria Insuficiente’? La NVIDIA RTX 4060 Ti 16GB, ¿Tu Solución?

¿Eres un entusiasta de la IA, desarrollador o artista digital que lucha constantemente contra el temido error de ‘Memoria Insuficiente’ (Out of Memory) al generar imágenes de alta resolución, entrenar modelos o ejecutar LLMs más grandes? Durante años, las GPUs asequibles a menudo significaban comprometer la VRAM, forzando decisiones difíciles sobre tamaños de lote o complejidad del modelo. La NVIDIA RTX 4060 Ti 16GB llegó con una promesa específica: una VRAM abundante para cargas de trabajo de IA sin arruinar el presupuesto. Pero, ¿realmente cumple esta promesa o hay algo más en la historia? Como un usuario avanzado de IA que ha puesto esta tarjeta a prueba, estoy aquí para darte la verdad, con sus virtudes y defectos.

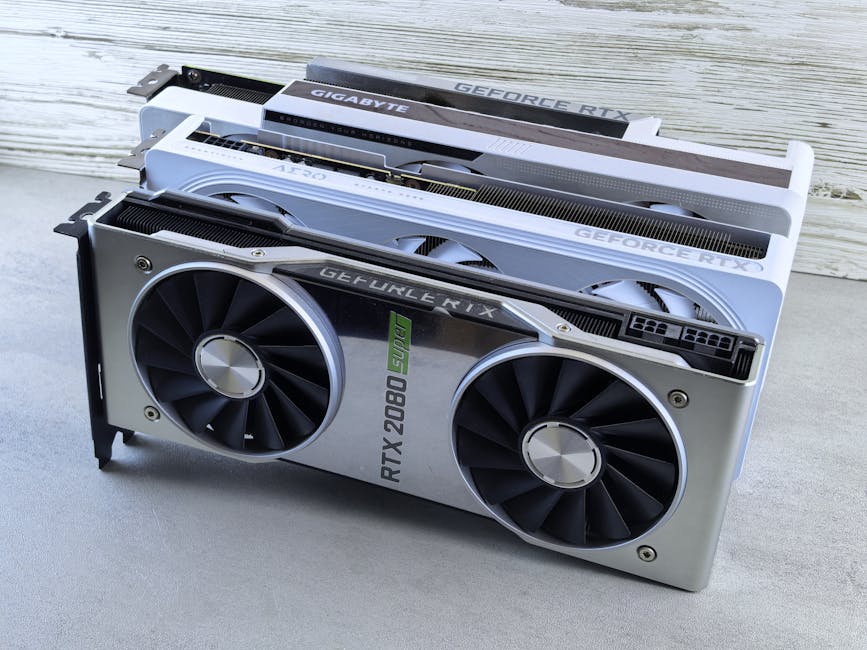

NVIDIA RTX 4060 Ti 16GB: Especificaciones Clave

| Especificación | Valor |

|---|---|

| Arquitectura GPU | Ada Lovelace |

| VRAM | 16GB GDDR6 |

| Núcleos CUDA | 4352 |

| Interfaz de Memoria | 128-bit |

| Ancho de Banda de Memoria | 288 GB/s |

| TDP | 160W |

| PVP (aprox.) | $499 USD |

Lo Bueno, Lo Malo y el Cuello de Botella: Pros y Contras de la 4060 Ti 16GB

👍 Pros

- Generosa VRAM de 16GB: Por su precio, esta es una característica sobresaliente. Es excelente para manejar grandes modelos de IA, generación de imágenes de alta resolución (piensa en 1024×1024 y más allá), y flujos de trabajo complejos de Stable Diffusion con múltiples ControlNets. ¡Di adiós a muchos errores de ‘Memoria Insuficiente’!

- Bajo Consumo de Energía: Un TDP de solo 160W la convierte en una opción energéticamente eficiente, reduciendo la carga sobre tu fuente de alimentación y ayudando a mantener bajas las temperaturas.

- Rendimiento Sólido en Juegos: Aunque nuestro enfoque es la IA, vale la pena señalar que ofrece un rendimiento respetable en juegos para su clase, lo que la convierte en una opción versátil.

- Ecosistema CUDA de NVIDIA: El acceso a la plataforma CUDA madura y extensa de NVIDIA es siempre una ventaja significativa para el desarrollo de IA, ofreciendo amplia compatibilidad de software y bibliotecas optimizadas.

👎 Contras (Una Perspectiva Crítica)

- El Bus de Memoria de 128 bits es un Gran Cuello de Botella: Este es el talón de Aquiles de la tarjeta para muchas tareas de IA. Aunque 16GB de VRAM es fantástico para la *capacidad*, la estrecha interfaz de 128 bits y el resultante ancho de banda de 288 GB/s a menudo significan que los datos no pueden alimentarse a los núcleos Ada Lovelace lo suficientemente rápido. Esto limita severamente la *velocidad* a la que su amplia VRAM puede ser utilizada en escenarios exigentes.

- Relación Precio-Rendimiento Cuestionable para la Computación Pura: Para cargas de trabajo de IA puramente intensivas en cómputo, la relación precio-rendimiento no siempre es convincente en comparación con algunas tarjetas de gama alta de la generación anterior (ej., una RTX 3090 usada) o tarjetas de gama superior de la generación actual. Estás pagando una prima por la VRAM, pero no necesariamente por la velocidad bruta.

- Velocidad de Generación en Stable Diffusion: Aunque puede manejar imágenes más grandes, la velocidad real de generación para Stable Diffusion a veces puede ser sorprendentemente cercana, o incluso más lenta, que tarjetas con menos VRAM pero buses de memoria más anchos (ej., una 3070 Ti). La capacidad de VRAM evita el OOM, pero el bus limita el rendimiento.

- No para Entrenamiento Serio a Gran Escala: Si planeas entrenar modelos fundamentales o realizar investigación intensiva en IA, los núcleos CUDA y el ancho de banda limitados se harán evidentes rápidamente. Es un excelente punto de partida, pero no una herramienta robusta para el desarrollo profesional de modelos a gran escala.

Análisis Profundo: Rendimiento Real en IA (Stable Diffusion, LLMs y Entrenamiento)

Cuando tuve en mis manos la RTX 4060 Ti 16GB por primera vez, mi pensamiento inmediato fue: «¡Finalmente, una tarjeta económica con VRAM real para IA!» Y en muchos sentidos, cumple con esa emoción inicial.

Para Stable Diffusion, los 16GB de VRAM son un verdadero cambio de juego para evitar errores de OOM. Pude generar imágenes de 1024×1024 sin esfuerzo, ejecutar tamaños de lote más grandes (ej., 4-6 imágenes a la vez) y experimentar con configuraciones complejas de ControlNet que involucraban múltiples modelos sin un solo problema. Aquí es donde la tarjeta realmente brilla, ofreciendo una flexibilidad incomparable a este precio. Sin embargo, surgió una observación crítica: aunque maneja la *capacidad* maravillosamente, la *velocidad* de generación a veces puede sentirse… bueno, algo lenta. El bus de memoria de 128 bits a menudo estrangula los núcleos Ada Lovelace. Por ejemplo, generar una imagen de 512×512 no fue drásticamente más rápido que con mi antigua 3060 12GB, y para resoluciones más altas, aunque la 4060 Ti 16GB *podía* hacerlo, una 4070 o 3080 lo completaría mucho más rápido.

Para la Inferencia de LLMs, esta tarjeta es sorprendentemente competente. Cargué y ejecuté con éxito varios modelos 7B y 13B (como Llama 2, Mistral, Zephyr) en cuantificación FP16 o Q8_0 completa, logrando velocidades de generación de tokens decentes. Los 16GB de VRAM son amplios para la IA conversacional de un solo usuario o el desarrollo de LLMs locales a pequeña escala. Ya no estás limitado a modelos pequeños y altamente cuantificados, lo que abre un mundo de exploración local de IA.

En cuanto al Entrenamiento en Python (PyTorch/TensorFlow): Para experimentación a nivel de entrada y ajuste fino de modelos más pequeños (ej., LoRAs para Stable Diffusion, CNNs pequeñas), los 16GB de VRAM permiten tamaños de lote significativamente mayores que sus contrapartes de 8GB. Esta es una clara ventaja, permitiéndote expandir los límites de tus proyectos de aprendizaje. Sin embargo, para un entrenamiento serio de modelos fundamentales o investigación compleja, los núcleos CUDA y el ancho de banda de memoria limitados mostrarán sus limitaciones. Es un buen trampolín para el aprendizaje y proyectos personales, pero no una solución robusta para el desarrollo profesional de modelos a gran escala.

El Veredicto Final: ¿Quién Debería Comprar la RTX 4060 Ti 16GB?

Entonces, después de ponerla a prueba, ¿para quién es realmente la NVIDIA RTX 4060 Ti 16GB?

✅ DEBERÍAS considerar esta tarjeta si:

- Eres un aficionado a la IA o creador de contenido centrado principalmente en Stable Diffusion, que necesita una VRAM amplia para evitar errores de OOM en imágenes de alta resolución, configuraciones complejas de ControlNet o tamaños de lote más grandes, y los juegos son una preocupación secundaria.

- Quieres ejecutar LLMs locales (modelos 7B-13B) para uso personal, experimentación o pequeños proyectos de desarrollo, beneficiándote enormemente de la capacidad de 16GB de VRAM.

- Tienes un presupuesto ajustado y necesitas absolutamente la mayor VRAM posible en una nueva GPU, incluso si eso significa reconocer las limitaciones del bus de memoria.

- Tu GPU actual alcanza frecuentemente los límites de VRAM, impactando severamente tu flujo de trabajo de IA.

❌ Probablemente DEBERÍAS OMITIR esta tarjeta si:

- Eres un investigador serio de IA o desarrollador profesional que requiere la máxima potencia de cómputo y ancho de banda para un entrenamiento intensivo de modelos, donde una 4070 Super/4070 Ti Super o incluso una 3090 usada ofrecería un valor significativamente mejor (aunque con mayor consumo de energía).

- Priorizas la velocidad bruta de generación en Stable Diffusion sobre la capacidad de VRAM, y estás dispuesto a manejar lotes o resoluciones más pequeñas.

- No estás alcanzando los límites de VRAM con frecuencia, y el rendimiento puro en juegos es tu principal preocupación, donde otras tarjetas podrían ofrecer una mejor relación fotogramas por dólar.

- Esperas un salto de rendimiento sustancial para tareas de IA en comparación con una 3060 12GB más allá de la mera capacidad de VRAM.

En conclusión, la RTX 4060 Ti 16GB es una tarjeta con un nicho muy específico. Resuelve brillantemente el ‘cuello de botella de VRAM’ para muchos usuarios y aficionados de IA de gama media, abriendo posibilidades que antes estaban fuera de alcance sin gastar mucho más. Sin embargo, su bus de memoria de 128 bits es un verdadero limitador de rendimiento, lo que significa que obtienes capacidad pero no siempre la velocidad bruta. Comprende tu carga de trabajo principal de IA y prioriza en consecuencia, y esta tarjeta podría ser una valiosa adición a tu configuración. ¡Elige sabiamente!

🏆 Elección del Editor

NVIDIA GeForce RTX 4060 Ti 16GB

Mejor modelo calidad-precio para IA

* Affiliate disclaimer: We may earn a commission from purchases.

#RTX 4060 Ti 16GB #GPU IA #Stable Diffusion Español #LLM Local #Review GPU #NVIDIA #Componentes PC